查看引用/信息源请点击:Nweon

生成更逼真、物理上更合理的3D交互姿态

(Nweon 2025年05月12日)从文本描述生成逼真的三维人-物交互(HOI)是一个活跃的研究课题,在虚拟和增强现实等领域具有潜在的应用前景。然而,由于缺乏大规模交互数据和难以确保物理合理性,特别是在域外(OOD)场景中,创建高质量的3D HOD依然具有挑战性。

目前的方法倾向于关注身体或手,这限制了它们产生逼真交互的能力。在一项研究中,来自中国科学院,中国科技学院大学,山东大学和北京科技大学等机构的团队提出了OOD-HOI。

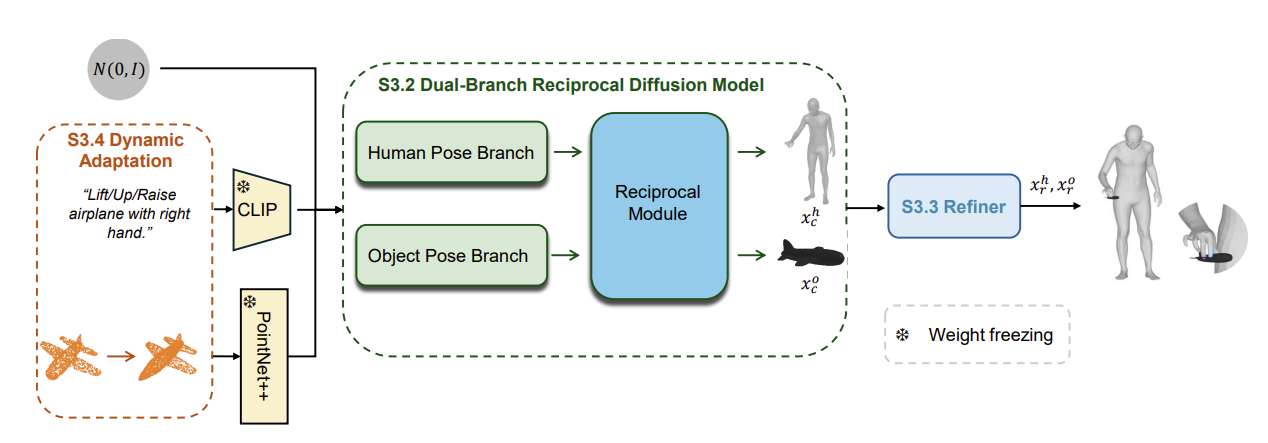

这是一个文本驱动的框架,用于生成全身人-对象交互,而它可以很好地泛化到新的对象和动作。所述方法集成了一个dual-branch反扩散模型来合成初始交互姿态,一个接触引导的交互精细化器来提高基于预测接触面积的物理精度,以及一个包括语义调整和几何变形在内的动态适应机制来提高鲁棒性。

实验结果表明,与现有方法相比,OOD- HOI可以在OOD场景中生成更逼真、物理上更合理的3D交互姿态。

文本驱动的三维人物交互合成(HOI)近年来备受关注,其目的是在人与物体之间产生连贯的、语义上有意义的交互。精确的3D HOI方法在虚拟现实和增强现实等各个领域显示出巨大的应用潜力。因此,为各种应用程序创建物理上合理且与上下文相关的3D场景至关重要。

尽管做出了显著的努力,但由于缺乏大规模交互数据和物理先验,从文本描述生成三维人机交互依然面临重大挑战。具体而言,与3D人体运动生成相比,现有的人-物交互数据集大约要小10倍。

另外,相关数据集是从特定场景(例如动捕或模拟)中收集。最近先进的文本到3D HOI方法在域外场景下表现出显著的性能下降,特别是在细粒度文本描述或基于图像的姿态估计器指导下的多样性和可控性方面。

另一方面,由于文本描述固有的模糊性,生成几何上和语义上合理的抓取物体的全身化身是具有挑战性的。

为了解决上述问题,现有的文本驱动3D HOI合成方法涉及扩展现有的扩散模型,以生成人-物交互,而这大致可分为两种:以身体为中心的方法和以手为中心的方法。

前一种方法侧重于建模身体-物体接触,捕获交互的一般运动趋势,但往往忽略手的精确作用。这种遗漏限制了它们产生完全真实的交互的能力,因为手在操纵物体时起着至关重要的作用。

另一方面,以手为中心的方法生成了手抓动作,但忽略了身体的其他部分,导致手的动作与身体的姿势和互动的背景不一致,从而导致不够现实的结果。

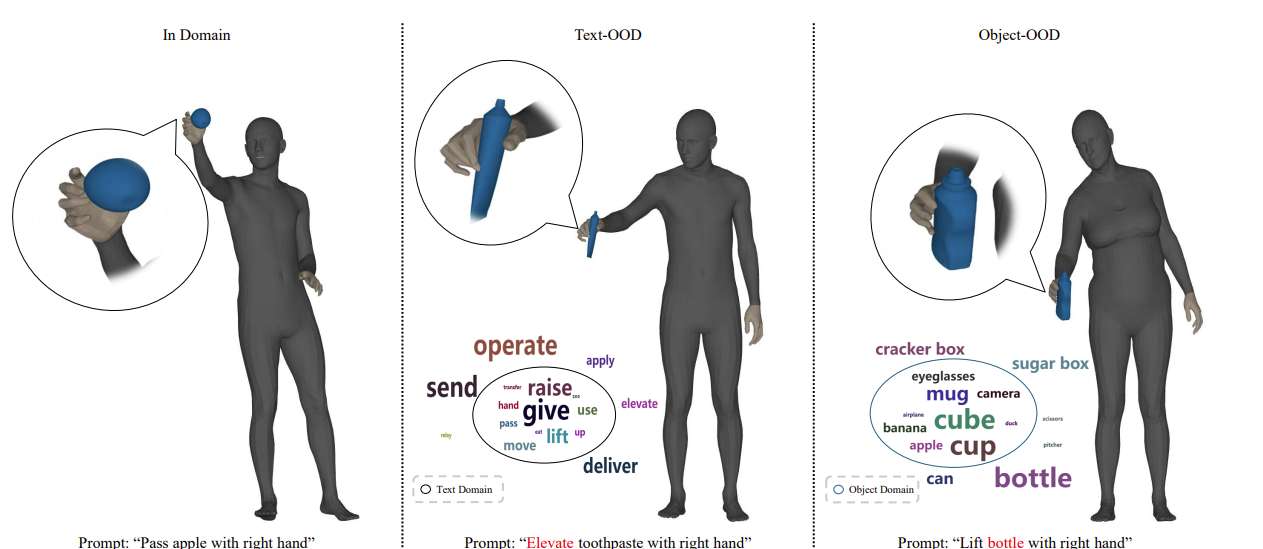

三维人机交互生成的另一个重要问题是处理域外(OOD)泛化。当训练模型遇到与训练数据显著偏离的提示时,例如新对象、不寻常的动作或模型以前从未见过的独特的人-对象组合,就会出现这种情况。

GraspTTA提出了域外对象泛化的测试时间适应范式,InterDreamer利用大语言模型生成相应的似是而非的人-对象交互。尽管相关方法在通常的动作层面方面已经实现了泛化能力,但在新对象层面,它们依然难以产生合理的上下文交互。

所以,团队结合人体、手和物体的生成,提出了一种新的文本驱动的三维人-物交互的域外生成方法,命名为OOD-HOI。

具体来说,提出的OOD-HOI包括三个组成:双分支互反扩散模型,接触引导的相互作用细化器和动态自适应。具体而言,dual-branch反扩散模块旨在从文本描述和物体点云以组合方式生成全身交互。

接触引导的交互细化器通过将预测的接触面积作为可在推断时应用于扩散过程的指导来修正相互作用姿态。

为了提高泛化能力,研究人员进一步提出了一种动态自适应方法来增强未见对象和各种文本描述的生成。具体来说,他们认为泛化的重点是文本描述和动作以及各种对象之间的对齐。因此,引入语义调整和几何变形来分别解决文本- OOD和对象- ODD问题。

相关论文:OOD-HOI: Text-Driven 3D Whole-Body Human-Object Interactions Generation Beyond Training Domains

总的来说,团队提出了一种新的文本驱动方法,通过联合考虑人体、手和物体之间的信息交换来生成全身人-物体交互。这是通过两阶段框架实现: